这是一个创建于 1066 天前的主题,其中的信息可能已经有所发展或是发生改变。

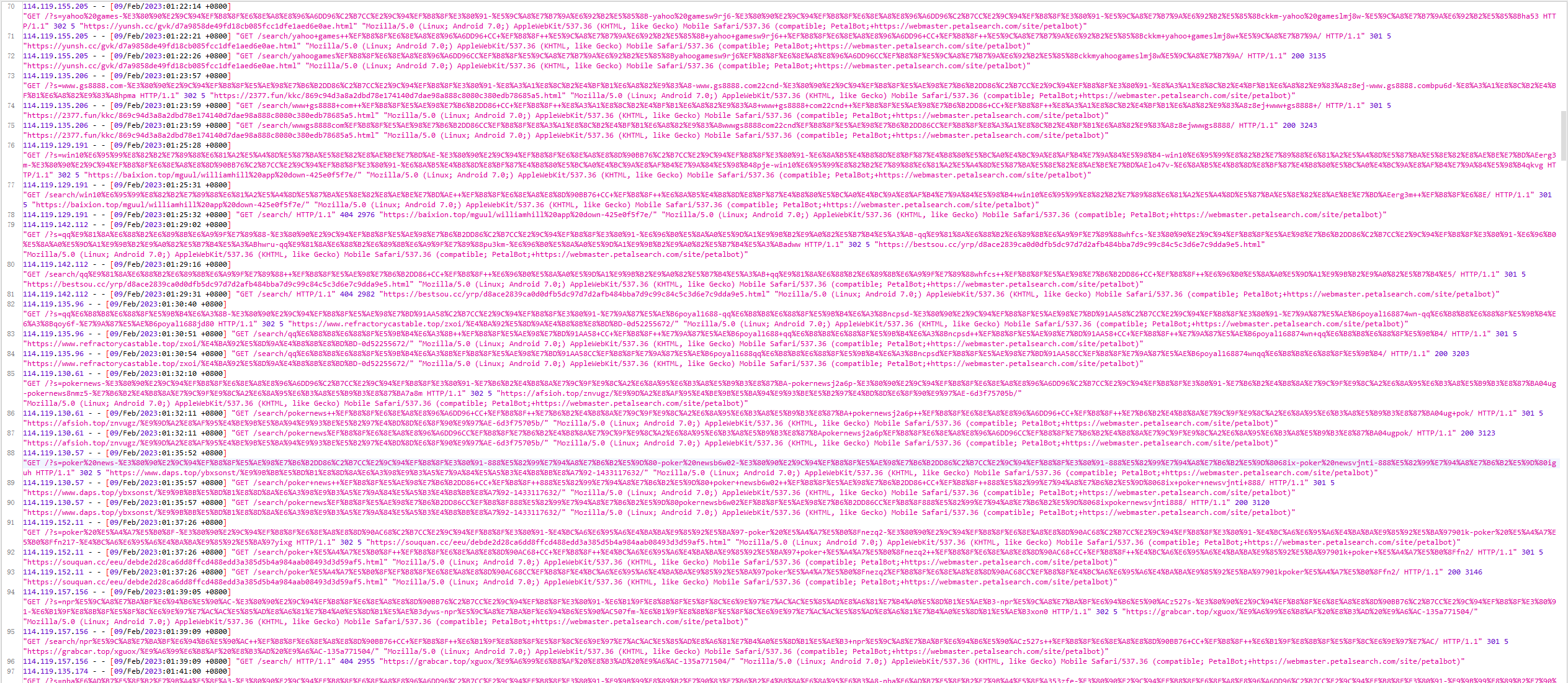

博客经常遭遇菠菜佬和 seo 佬的骚扰,而且是通过搜索引擎的 bot 请问该如何禁止?

1

Windelight 2023 年 2 月 9 日 via Android

被利用的链接直接反回 404

|

2

Yourshell 2023 年 2 月 10 日

你也是闲的去翻日志

可以套个 CF 然后 WAF 开高点 |

3

z86823237 2023 年 2 月 10 日

你可以在 web 服务器的重写或配置层面加上拦截规则,

例如:将$user_agent 包含:"PetalBot" 内容的请求,全部返回 404 或 nginx 444; |

4

momocha 2023 年 2 月 10 日 via iPhone 更新你的 /robots.txt 把要禁止的 user-agent 加入黑名单,遵守规则的爬虫就不会来了。

|

5

opengps 2023 年 2 月 10 日

只要没浪费你太高流量,无视即可,干嘛用人工的精力去对抗机器人

|

6

woshinide300yuan 2023 年 2 月 10 日

@opengps wordpress 的话,经常遇到利用搜索关键词来生成搜索页面,然后不久后就被搜索引擎收录了,就导致自己站点在百度的搜索结果中,出现一大堆 “ #&@*#&@*|xx 博客 ” 的垃圾广告收录,跟被黑了似的。

其他的不知道,所以就都很介意垃圾词搜索。 ======== LZ 如果是 WP 的话,可以考虑下一个插件 wpjam ,里面配套的一款插件是优化 WP 搜索的,包括频率、字符限制。 我看 /?s=后面跟了一大堆字符,不出意外肯定可以限制了。 其他就不知道了。 蹲一个更高明的,学习一下。 |

7

hangbale 2023 年 2 月 10 日

我的也有这种情况,这种爬虫 IP 一般有规律,我直接在 nginx 里把这些 ip 给 deny 了

|

8

NoAnyLove 2023 年 2 月 10 日

菠菜佬是啥?

以前用过 fail2ban ,套个现成的 403-404 规则就行 |

10

mytsing520 PRO @NoAnyLove

执行菠菜关键字的 |

11

isbase PRO cloudflare

|

12

proxytoworld 2023 年 2 月 10 日 @momocha 干灰黑产的不会理 robots.txt 的

|

13

vevlins 2023 年 2 月 10 日

楼上有的同学理解好像有偏差。

现在的问题不是灰产访问 op 的网站,而是黑帽 seo 通过构造链接提升自己的外链数量和站点权重。这点在 shopify 站点尤为突出。主要修改自己的搜索链接的拼接规则,比如对敏感词过滤或者没结果的不要显示搜索词。另外你也可以在 google 等引擎上注册自己的网站,提交黑名单路径,防止构造的链接被收录。https://www.cifnews.com/article/138714 上面说的 robots 没有问题,是其他同学理解错了,本来就是避免 google 、baidu 收录。套 cf 的也搞错了吧,不是防止 cc 等恶意扫描攻击。 |

15

iqoo 2023 年 2 月 10 日 重定向到挖矿页面

|

16

lianyue 2023 年 2 月 10 日

这个如果 你没有 fullpath 长度大于 100 页面 直接 fullpath.length > 100 返回 403 就好了

|

17

kleos OP @woshinide300yuan 我使用的是 typecho

|

18

woshinide300yuan 2023 年 2 月 10 日

@kleos 如果是宝塔面板的话,就装一个免费的第三方插件叫什么 nginx 防火墙,把这个 p 什么 bot 的 ua 放到封禁里。

如果不是的话,就百度“nginx UA 封禁”,代码也挺简单的。主要这个截图里的东西,很规律……直接禁止这个 UA 访问就好了。 我想不到其他的了…… |

19

kleos OP @woshinide300yuan 按照 ua 或者根据 cidr 当然能禁,但是不想误伤搜索引擎的收入

|

20

yagamil 2023 年 2 月 18 日

宝塔里面或者你的云主机厂商,可以有根据 ua 过滤的功能。

|