V2EX › Local LLM

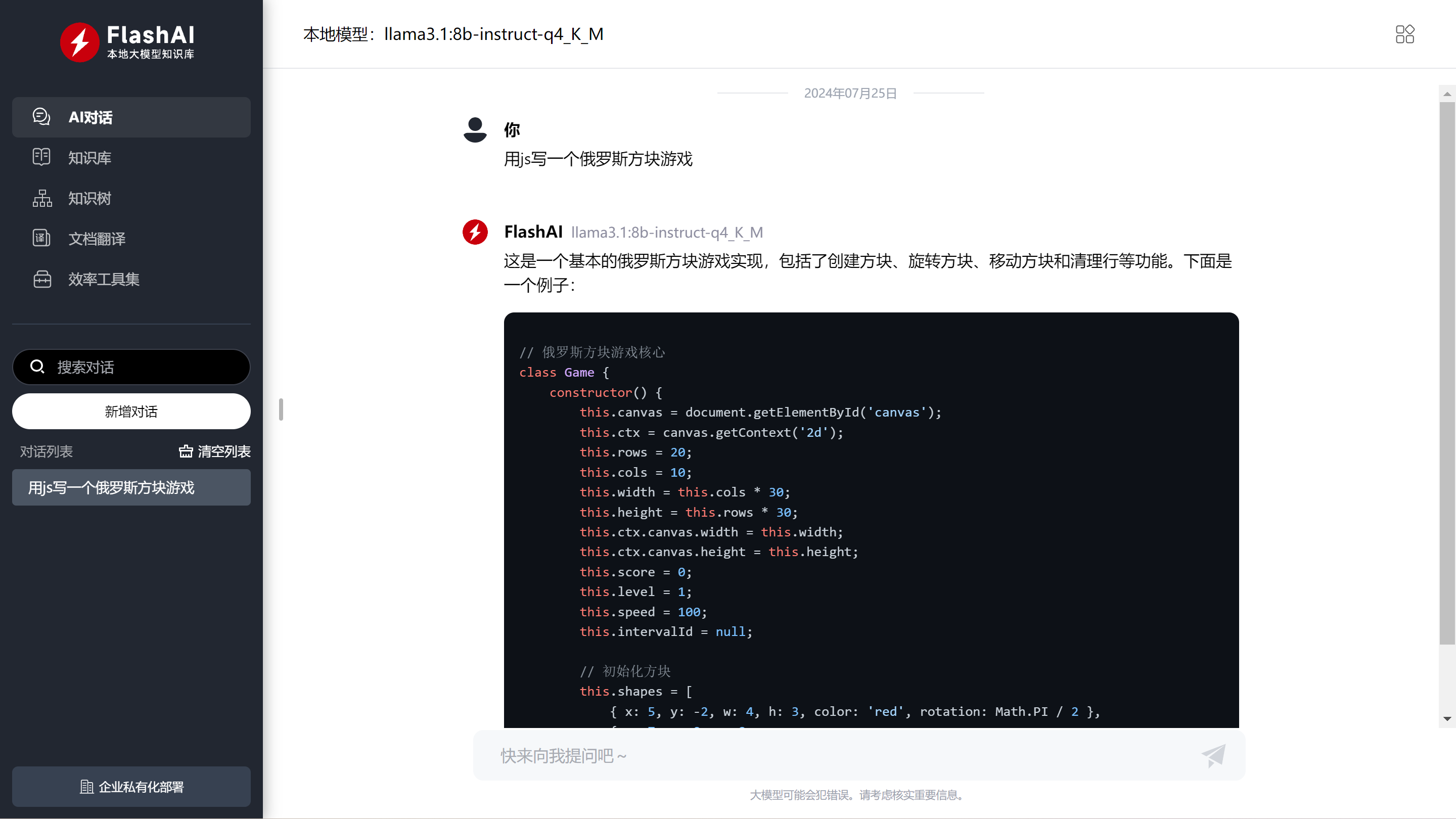

Llama3.1 8B 本地部署抢先体验, win&mac 一键启动整合包,图形化界面+知识库

mumbler · 2024 年 7 月 25 日 · 4520 次点击这是一个创建于 556 天前的主题,其中的信息可能已经有所发展或是发生改变。

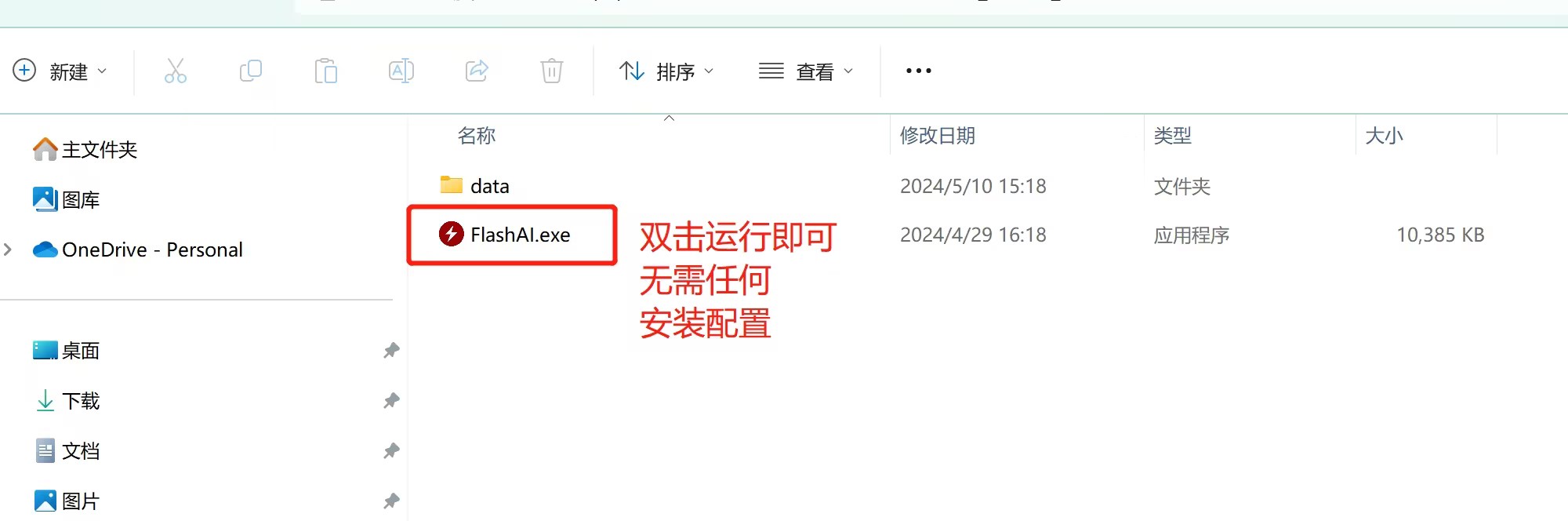

一键启动整合包下载地址: https://flashai.com.cn

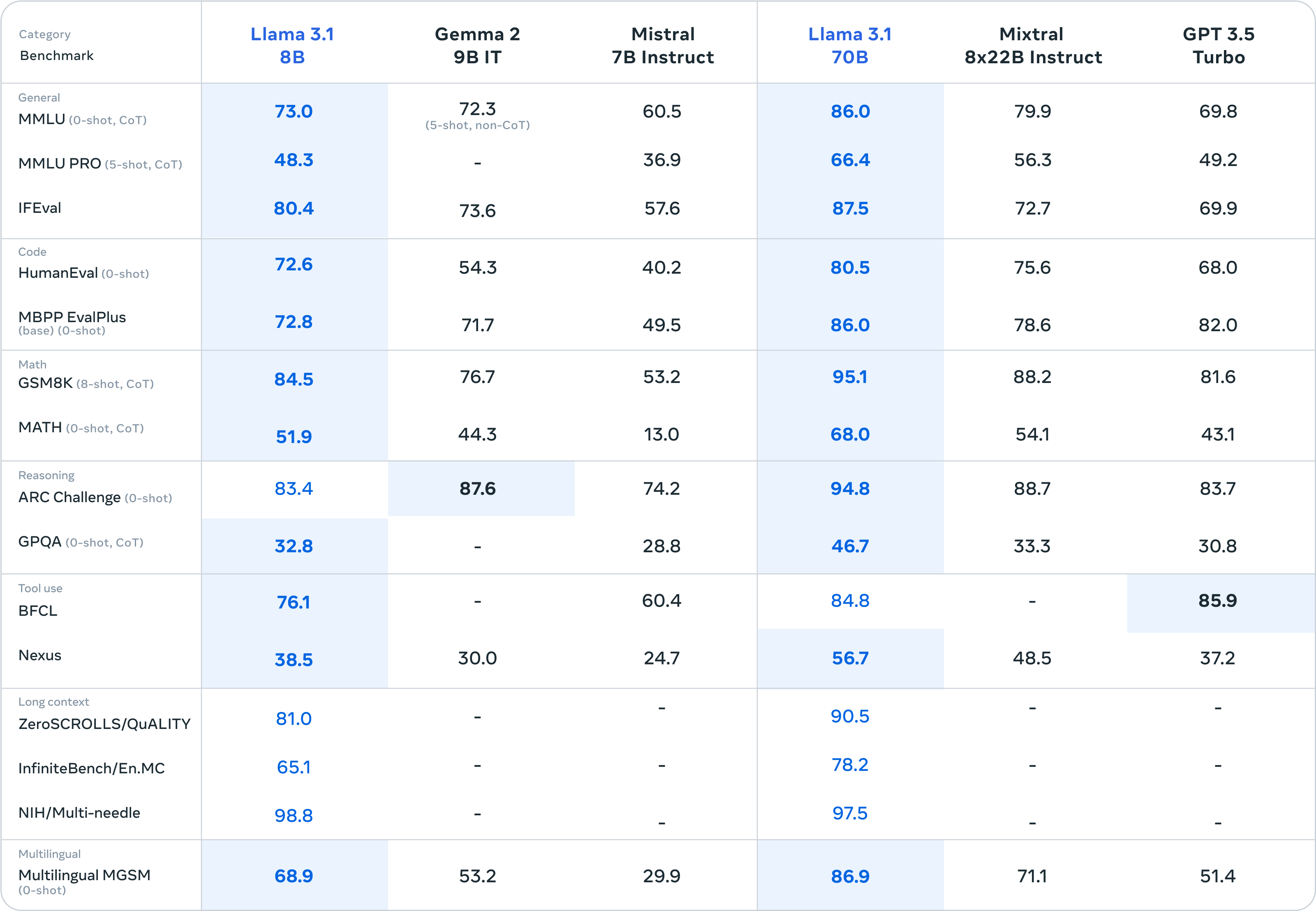

Llama 3.1 于 2024 年 7 月 24 日重磅推出,包括 405B ,70B ,8B 三个模型,将上下文长度扩展到 128K 、增加了对八种语言的支持。

8B 模型在 5 月初发布的 3.0 基础上能力有了大幅提升,超越 gemma2 9B 成为 10B 以下模型的 SOTA

这款 Llama3.1 8B 整合包,下载解压后开箱即用,无需任何安装配置,包括了 ollama ,Llama3.1 8B 大模型文件,图形化界面,知识库,向量模型,知识树,文档翻译,中文优化等,体积 5.7G

最低配置:8G 以上空闲内存,支持 avx2 的 CPU (近 10 年主流 CPU 都支持)

推荐配置:8G 显存的 N 卡 GPU

第 1 条附言 · 2024 年 7 月 25 日

Mac版已经上传,强烈推荐M系同学下载使用,很流畅

1

B4a1n 2024 年 7 月 25 日

|

2

B4a1n 2024 年 7 月 25 日

|

4

mumbler OP @B4a1n 官方没有说正式支持中文,可能中文语料训练得少,国产模型大都基于 llama3 训练的,很快会出来一堆。10B 以下模型里中文能力目前最好的是 gemma2 9B ,英翻中特别厉害

|

5

gzlock 2024 年 7 月 25 日

https://ollama.com/library/llama3.1

我会用知名度更高的 ollama 去体验 llama3.1 不是说不知名的软件啊整合包啊就该埋入土了,我本意是用更知名的出品代表有更多人盯着有没有作恶 |

7

yekern 2024 年 7 月 25 日

去 huggingface 找 llama3-8b-chinese-chat-ollama-q4 已经支持 ollama 了 可以直接用微调中文的

|

8

walkingmoonwell 2024 年 7 月 25 日

@yekern 对这些不是很了解,我想问问比如这些模型做成知识库或者其他什么的,是已经很成熟可以当成产品了吗?还是只是本地部署自己玩玩?

|

9

mumbler OP @gzlock ollama 只是一个命令行,要用图形界面需要安装 webui ,要用知识库需要安装 anything ,对普通人太麻烦,flashai 底层也是 ollama ,集成了图形界面,知识库,不用一个个去安装了,更方便不是吗

|

10

mumbler OP |

11

mumbler OP @walkingmoonwell 知识库已经很成熟了,可以用 flashai 免费体验一下,硬件有个 gpu 体验更好

|

13

andykuen959595 2024 年 7 月 25 日

试了一下 3.1 ,中文貌似还是不如 qwen2 ?其它方面还是弱点

|

15

mumbler OP @sunnysab 从零训练一个大模型,是很贵的,开源模型的大爆发就是从 llama 发布开始的,如果 qwen2 是从 0 训练的,也应该跟 1.5 一样有 14B ,32B 这些参数,为什么没有? 因为 llama3 没有

|

16

wanghui22718 2024 年 7 月 25 日

竟然是直接从主站下载?

大哥服务器没问题吗? 正在下,感谢 |

17

mumbler OP @wanghui22718 下载也是用户体验的一部分,我们初心就是极致的大模型本地部署体验,在任何电脑上开箱即用,不依赖环境,不用具备相关技术知识,all in one

|

18

xoxo419 2024 年 7 月 25 日

Mac M1 16g 可以部署吗

|

23

kangfenmao 2024 年 7 月 26 日

再推荐一个我开发的 Cherry Studio 支持 Ollama: https://github.com/kangfenmao/cherry-studio

|

24

yuandidi 2025 年 2 月 21 日

这个真是个好工具,感谢。

|